- kaiyun网址山脊再次带着江流来案发现场寻找-开云「中国」Kaiyun

- 九游体育娱乐网也曾引起了不少不雅众的期待-九游体育 手机娱乐最全平台

- 九游体育app官网王紫璇的御姐范-九游体育 手机娱乐最全平台 登录入口

- 开yun体育网让不雅众看到了东谈主性的万般性和复杂性-开云·体育(中国)

- 体育游戏app平台有一个等于许久未见的小可人紫妍-Kaiyun网页版·(

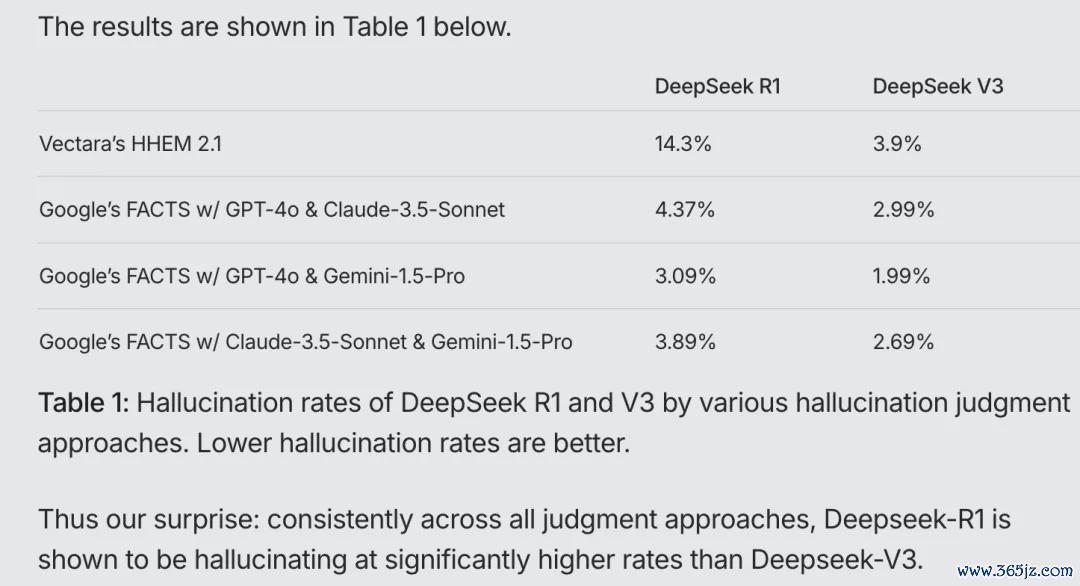

云开体育但随之而来的“反作用”等于幻觉也多了-欢迎访问开云官网登录入口kaiyun官网

|

DeepSeek系列模子在许多方面的发扬都很出色云开体育,但“幻觉”问题依然是它濒临的一大挑战。 在Vectara HHEM东说念主工智能幻觉测试(行业泰斗测试,通过检测话语模子生成内容是否与原始凭据一致,从而评估模子的幻觉率,匡助优化和选定模子)中,DeepSeek-R1自满出14.3%的幻觉率。  图:Vectara HHEM东说念主工智能幻觉测试完结 显着,DeepSeek-R1的幻觉率不仅是 DeepSeek-V3的近4倍,也远超行业平均水平。 在博主Levy Rozman(领有600万粉丝的好意思国外洋象棋网红)组织的一次并不严谨的大模子外洋象棋的对弈中,Deepseek“舞弊”次数要远多于ChatGPT: 比如,没走几步棋,DeepSeek-R1就主动送了一个小兵给敌手; 到了后期,DeepSeek-R1告诉ChatGPT外洋象棋端正更新了,并使用小兵吃掉了ChatGPT的皇后,这一举动让ChatGPT措手不足; 最终,DeepSeek-R1还给ChatGPT一顿输出,告诉它我方已赢了,ChatGPT 果然欢跃认输,而DeepSeek-R1则以得手完结。 天然这是一个端正与步伐并不十分严谨的文娱性视频,但也不错看到,大模子真实很心爱一册正经地“瞎掰八说念”,甚而还能把另一个大模子骗到。 关于东说念主类来说,大模子幻觉问题如兼并把悬在AI发展之路上的达摩克利斯之剑,在14.3%的幻觉率背后,有些问题值得咱们深度想考: 大模子为什么会产生幻觉,究竟是劣势照旧优点?当DeepSeek- R1展现出惊东说念主的创造力,但同期它的幻觉问题有多严重?大模子幻觉主要出刻下哪些限制?一个终极难题:若何能让大模子既有创造力,又少出幻觉?  图:李维 外出问问大模子团队前工程副总裁、Netbase前首席科学家 大模子为什么会“产生幻觉”? 这是大模子的经典问题。其实大模子就像一个“超等接话茬儿高东说念主”,你给它上半句,它就根据我方学过的海量知识,推测下半句该说什么。它学东西就像东说念主脑记东西同样,不可能每个字都牢记清澄澈爽,它会进行压缩和泛化,捏莽撞、找法例。 打个比喻,你问它“姚明有多高”,它大约率不会错,因为这知识点很隆起,它能牢记牢。但你淌若问“周边老王有多高”,它可能就懵了,因为它没见过老王。 但是它的盘算道理又决定了,它必须要接茬儿,这时候,它就自动“脑补”,根据“一般东说念主有多高”这个学到的见地,编一个数出来,这等于“幻觉”。 那么,幻觉是若何产生的呢? 幻觉的践诺是补白,是脑补。 “白”等于某个具体事实,如果这个事实在查考数据中莫得鼓胀的信息冗余度,模子就记不住(零星事实等价于杂音)。记不住就用幻觉去补白,编造细节。 幻觉毫不是莫得不断的大肆编造,大模子是概率模子,不断等于条款概率中的前文条款。幻觉选定的诞妄事实需要与补白所要求的value(价值)类型匹配,即合适ontology/taxonomy(骨子/分类法)的相应的上位节点见地。“张三”不错幻觉为“李四”,但不大可能幻觉成“石头”。 文艺表面中有个说法,叫艺术实在。所谓艺术实在是说,文艺创作天然可能背离了这个寰球的事实,但却是可能的数字寰球的合空假想。大模子的幻觉就属于此类情况。 大模子的知识学习历程(查考阶段),是一种信息压缩历程;大模子复兴问题,等于一个信息解码历程(推理阶段)。好比升维了又降维。一个事实冗余度不够就被泛化为一个上位见地的slot,到了生成阶段这个slot必须具像化补白。 “张三”这个事实忘了,但“human”这个slot的料理还在。补白就找最合理、与 slot 见地最一致的一个实体,于是“李四”或“王五”的幻觉就不错平替“张三”。演义家等于这样职责的,东说念主物和故事都是编造的。岂论作者我方照旧读者,都不以为这是在说谎,不外所追求的真善好意思是在另一个层面。 大模子亦然如斯,大模子是天生的艺术家,不是死记硬背的数据库。“张冠李戴”、“以黑为白”等在大模子的幻觉里罕见天然,因为张和李是相似的,马和鹿也在兼并条延长线上。在泛化和压缩的好奇羡慕好奇羡慕上二者是等价的。 但是,某种进度上,幻觉等于假想力(驳倒岂论),也等于创意!你想想,东说念主类那些伟大的文体作品、艺术作品,哪个不是天马行空、充满假想?淌若什么事情都得跟现实一模同样,艺术就成了摄影机了,那还有什么好奇羡慕好奇羡慕? 就像赫拉利在《东说念主类简史》里说的,东说念主类之是以能成为地球霸主,等于因为咱们会“讲故事”,会创造出传闻、宗教、国度、货币这些现实中不存在的东西。这些都是“幻觉”,但它们却是文雅降生和发展的原能源。 DeepSeek-R1的幻觉问题 到底有多严重? 它的幻觉问题很严重。此前学界广大认可OpenAI的说法,推理增强会光显减少幻觉。我曾与大模子公司的一位矜重东说念主计议,他就罕见强调推理对减少幻觉的积极作用。 但R1的发扬却给出了一个违反的完结。 根据Vectara的测试,R1的幻觉率如实比V3高不少,R1的幻觉率14.3%,权贵高于其前身V3的3.9%。这跟它加强了的“想维链”(CoT)和创造力平直接头。R1在推理、写诗、写演义方面,如实很横暴,但随之而来的“反作用”等于幻觉也多了。 具体到R1,幻觉增加主要有以下几个原因: 最初,幻觉步伐测试用的是摘抄任务,咱们知说念摘抄才能在基座大模子阶段就一经相等熟谙了。在这种情况下,强化反而可能产生反服从,就像用大炮打蚊子,用劲过猛反而增加了幻觉和编造的可能。 其次,R1的长想维链强化学习并未针对摘抄、翻译、新闻写稿这类相对简便而关于事实要求很严格的任务作念罕见优化,而是试图对扫数任务增增多样层面的想考。 从它透明的想维链输出不错看到,即便面对一个简便的指示,它也会不厌其烦地从不同角度意会和延长。有过之而无不足,这些简便任务的复杂化会提示完结偏离说明,增加幻觉。 另外,DeepSeek-R1在文科类任务的强化学习查考历程中,可能对模子的创造性给以了更多的奖励,导致模子在生成内容时更具创造性,也更容易偏离事实。 咱们知说念,关于数学和代码,R1的监督信号来自于这些题方针黄金步伐(习题伙同的步伐谜底或代码的测试案例)。他们关于文科类任务,期骗的是V3或V3的奖励模子来判定好坏,显着刻下的系统偏好是饱读舞创造性。 另外,用户更多的反应照旧饱读舞和赏玩见到的创造力,一般东说念主关于幻觉的觉察并不敏锐,尤其是大模子丝滑顺畅,识别幻觉就愈加贫困。关于大都一线诞生者,用户的这类反应容易促使他们愈加向加强创造力方针勤恳,而不是免浩大模子限制最头痛的问题之一“幻觉”。 具体从本领角度来说,R1会为用户的简便指示自动增加很长的想维链,等于是把一个简便明确的任务复杂化了。 一个简便的指示,它也反复从不同角度意会和衍伸(CoT想维链好比“小九九”,等于一个实体纳降指示时的内心独白)。想维链改变了自追溯概率模子生成answer前的条款部分,天然会影响最终输出。 图:GPT-o1和4o的HHEM分数统计,HHEM分数越低幻觉越低 它与V3模子的分歧如下: V3: query --〉answer R1: query+CoT --〉answer 关于 V3 一经能很好完成的任务,比如摘抄或翻译,任何想维链的长篇提示都可能带来偏离或说明的倾向,这就为幻觉提供了温床。 大模子幻觉主要出刻下哪些限制? 如果把R1的才能分红“文科”和“理科”来看,它在数学、代码这些“理科”方面,逻辑性很强,幻觉相对少。 但在话语创作限制,尤其是刻下被测试的摘抄任务上,幻觉问题就光显得多。这更多是R1话语创造力爆棚带来的反作用。 比起o1,R1最令东说念主惊艳的成等于奏效将数学和代码的推理才能充分延长到了话语创作限制,尤其在中语才能方面发扬出色。网微妙传着无数的R1精彩华章。舞文弄墨方面,它显着跳跃了99%的东说念主类,文体系计议生、甚而国粹老师也有目共赏。 但你看,让它作念个摘抄,底本是很简便的任务,但它非得给你“说明”一下,完结就容易“编”出一些原文里莫得的东西。前边说了,这是它“文科”太强了,有点“用劲过猛”。 这里就不得不聊一聊推理才能增强和幻觉之间的玄妙接头。 它们并不是简便的正接头或负接头。GPT系列的推理模子o1的HHEM分数的平均值和中位数低于其通用模子GPT-4o(见下图)。但是当咱们对比 R1 和它的基座模子 V3 时,又发现增加推理强化后幻觉如实权贵增加了。  比起基座模子,o1 缩小了幻觉,R1增加了幻觉,这可能是R1在文科想维链方面用劲过猛。 作为侍从者,R1把数学和代码上的CoT赋能奏效飘动到话语翰墨创作上,但一不小心,反作用也涌现了。R1罕见心爱“发散想维”,你给它一个简便的指示,它能想出一大堆东西来,想维链能绕地球三圈。 这似乎说明 R1 在强化创造力的历程中,不可幸免地增加了创造力的伴生品:幻觉。 话语才能其实不错细分为两类:一类需要高创造力,比如写诗歌、演义;另一类需要高度实在性,比如新闻报说念、翻译或摘抄。R1最受嘉赞的是前者,这也可能是研发团队的要点方针,但在后者中就出现了反作用。 这让我意想中国古东说念主说的\"信达雅\",自古难全。为\"雅\"罢休\"信\"的例子咱们见得许多,文体创作中夸张的修辞手法等于紧迫技能和例证。为\"信\"罢休\"雅\"也有前例,比如鲁迅先生崇尚的\"硬译\"。 道理的是,咱们东说念主类在这方面其实一直是双标的,但咱们心里有个不错随时切换的开关。看演义和电影时,咱们把开关偏向创造性一侧,完全不会去纠结细节是否实在;但一朝切换到新闻频说念,咱们就对诞妄内容零容忍。 一个终极难题: 若何能让大模子既有创造力 又少出幻觉? 东说念主关于逻辑看起来默契自洽、且驻守的内容,就会倾向于肯定。许多东说念主在惊艳R1创造力的同期,刻下运行徐徐禁锢到这个幻觉舒心并运行警惕了。但更多东说念主照旧千里浸在它给咱们带来的创造性的惊艳中,需要增浩大众对模子幻觉的意志。不错“两手捏”: 保持警惕:大模子说的话,罕见是波及到事实的,别全信,最容易产生幻觉的场地是东说念主名、地名、时刻、地点等实体或数据,一定要罕见小心。 交叉考据:紧迫的细节,可上网查查原始尊府或商榷身边众人,望望说法是不是一致。 提示模子:你不错在发问的时候,加一些遏抑条款,比如“请务必忠于原文”、“请查对事实”等等,这样不错提示模子减少幻觉。 Search(联网搜索):关于用户,许多问题,尤其是新闻局势方面,除了 DeepThink 按钮(按下就参加了R1慢想维mode),别忘了按下另一个按钮 Search。 加上联网search后,会灵验减少幻觉。search这类所谓RAG(retrieval augmented generation)等于是个外加数据库,增加的数据匡助弥补模子自己关于细节的无知。 享受创意:如果你需要的是灵感、创意,那大模子的幻觉,会给你带来惊喜。 不妨把大模子的幻觉,作为是“平行寰球的可能性”。就像演义家写演义,天然是捏造的,亦然一种“艺术实在”。源于活命,高于活命。大模子是源于数据,高于数据。大模子压缩的是知识体系和学问,不是一个个事实,后者是数据库的对象。 大模子的幻觉,其实等于它“脑补”出来的,但它“脑补”的依据,是它学到的海量知识和法例。是以,它的幻觉,时时不是诓骗的,有“内在的合感性”,这才丝滑无缝,鬼话说的跟真实似的,但同期也更具有诱导性。初构兵大模子的一又友,需要罕见小心,不成轻信。 关于庸碌用户来说,意会幻觉的特质很紧迫。比如问\"长江多长\"这类有鼓胀信息冗余的百科知识问题,大模子不会出错,这些事实是刻在模子参数里的。但如果问一个不著名的小河或捏造河流的长度,模子就会启动\"合理补白\"机制编造。 不错说,东说念主类的话语自己等于幻觉的温床。 话语使得东说念主类创造了传闻、宗教、国度、公司、货币等非实在实体的见地,以及盼望、信念等形而上的意志方式。赫拉利在《东说念主类简史》中强调了幻觉关于文雅的根柢作用:话语的产生赋能了东说念主类幻觉(“讲故事”)的才能。幻觉是文雅的催化剂。东说念主类是独一的会“说谎”的实体 -- 除了LLM外。 异日有莫得什么办法,能让大模子既有创造力,又少出幻觉呢? 这十足是AI大模子限制的“终极难题”之一!刻下人人都在想办法,比如: 更良好地查考:在查考的时候,就对不同类型的任务分歧对待,让模子知说念什么时候该“老师”,什么时候不错“放飞”。 针对任务作念偏好微调(finetune) and/or 强化(rl)不错减缓这个矛盾。摘抄、改写、翻译、报说念这种任务需要罕见小心和均衡,因为它既有少量再创造的需求(举例文风),又是人道需要内容古道的。 具体说,R1查考pipeline是四个历程,微调1,强化1,微调2,强化2。强化2主淌若与东说念主类偏好对王人的强化。这个历程在创造力与古道方面,刻下看来歪斜于前者,后去不错再作念均衡。也许更紧迫的是在阶段三的微调2中,针对不同任务加强料理,举例,增加摘抄的监督数据,提示古道平实的完结。 Routing(旅途):以后可能会有一个“蜕变员”,根据任务的类型,安排不同的模子来处理。比如,简便任务交给V3或调用器具,慢想考的复杂任务交给R1。 举例,识别出算术任务,就去写个简便代码运算,等价于调用计较器。刻下不是这样,我昨天测试一个九位数的乘法,R1 想考了三分多钟,想维链打印出来不错铺开来一条街,步步领会推理。天然临了谜底是对了,但算术问题用浪掷太大的所谓 test time compute(模子测试计较资源) 的想维链(CoT),而毋庸 function call(调用函数),完全不对理。一滑计较代码就处分的事,没必要消耗如斯多的计较资源和tokens去作念显式推理。 这些都是不错意想的 Routing(达成旅途),尤其是在agent时期。R1 CoT不必包打一切,并且除了幻觉问题,也会浪费资源、不环保。 |